- Un exercice de mathématiques au Bac en Ecosse a posé tellement de difficultés aux candidats au bac écossais que le barème de l’épreuve a dû être revu…

Jugeant l’exercice du crocodile trop difficile au même titre que l’ensemble de l’examen, les candidats écossais au Higher Maths exam, l’équivalent de l’épreuve de mathématiques du baccalauréat français, ont lancé une pétition en mai 2015. Intitulée « Expliquez-nous pourquoi l’examen de mathématiques a été élevé à un niveau impossible », elle a recueilli plus de 11 000 signatures, aboutissant à un abaissement de la note requise lors de cette épreuve pour obtenir le diplôme.

Je vais démontrer ici pourquoi le niveau en maths a vraiment baissé par rapport à autrefois, par l’examen analytique du problème. C’est catastrophique au même titre que ce qui se passe en France : le nivellement par le bas.

Un exercice de niveau Terminale, croyez-vous ? Non, moi je dirais plutôt de niveau 4e de collège… On va voir pourquoi.

L’exercice demande d’estimer en combien de temps le crocodile atteindra le zèbre, selon s’il se déplace dans l’eau ou sur terre.

« Un crocodile a repéré une proie située à 20 mètres de lui sur la berge opposée d’une rivière. Le crocodile se déplace à une vitesse différente sur terre et dans l’eau. Le temps que met le crocodile à atteindre le zèbre peut être réduit s’il traverse la rivière en visant un certain point P, placé à x mètres du point de départ sur l’autre rive (voir schéma).

Le temps T nécessaire pour faire le trajet est donné par l’équation indiquée ci-dessous (en dixièmes de seconde).

Calculer en combien de temps le crocodile rejoindra le zèbre uniquement à la nage.

Calculer en combien de temps le crocodile rejoindra le zèbre s’il coupe la rivière au plus court.

Entre ces deux extrêmes, il existe une valeur de x qui minimise le temps nécessaire. Trouver cette valeur de x et en déduire ce temps minimum. »

Tout d’abord, pour résoudre le problème, on va examiner l’équation et le schéma.

Une vitesse c’est une distance divisée par un temps. Donc le temps est égal à une distance divisée par une vitesse.

Vous remarquez que le trajet dans la rivière est une hypoténuse de triangle-rectangle. Je pose R la largeur de la rivière, puis L la longueur de l’hypoténuse, et on a x (déjà défini) qui est le 3e côté.

On sait avec Pythagore que R² + x² = L². C’est classique.

Je pose T1 tel que T1 = L / V1, où T1 est le temps parcouru exclusivement dans la rivière, et où V1 est la vitesse du crocodile dans la rivière.

Je pose T2 tel que T2 = (20 – x) / V2, où T2 est le temps parcouru exclusivement sur terre, hors de la rivière, et où V2 est la vitesse du crocodile sur la terre ferme.

Je pose T(x) = T1 + T2, pour avoir T(x) qui est la durée total des trajets.

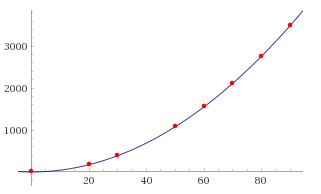

Mais aussi, on a T1 = L / V1 = (x² + R²)^(1/2) / V1. On obtient donc la forme T(x) = [(x² + R²)^(1/2) / V1] + [(20 – x) / V2] qui est exactement la forme de l’équation de l’énoncé : T(x) = 5(36+x²)^(1/2) + 4(20-x).

Pour le calcul du temps le plus court, il est alors exclu que le crocodile se déplace uniquement en rivière, ou uniquement sur terre, il y a obligatoirement une étape en rivière et une étape sur terre ferme.

Pour calculer le temps T(x) le plus court, on remarque que la fonction atteint un point x où T est minimum, alors on calcule la dérivée dT(x)/dx = 0, et je trouve x = 8 mètres. Pour les autres valeurs de x, le temps est plus long.

Si on pose x = 20 mètres, alors le crocodile ne fait que nager, sans étape sur terre ferme. Une partie de l’équation s’annule, et on aura T(x) = (x²+R²)^(1/2) / V1 = 5(36+20²)^(1/2) = 104,4.

Si on pose x = 0 mètre, alors le crocodile ne fera que marcher sur terre ferme, hors de la rivière (excepté le trajet R), et T(0) = 110.

Tandis qu’avec x = 8 mètres, on aura le temps le plus court : T(8) = 98.

J’ai répondu aux trois questions de l’exercice, cela n’a pris que quelques minutes… Affirmer que l’exercice est insoluble, c’est se foutre du monde, vraiment !

Au fond, le problème n’est pas les maths. Le problème des élèves est simple : ils ne savent pas lire un énoncé, par incompréhension de leur propre langue maternelle, et aussi parce qu’ils n’ont pas appris à réfléchir et à raisonner. Sans ces clés, on ne peut rien produire de bon en maths.

Peut-être que certains trouveront que j’exagère. Non, je suis sérieux.

- Autre preuve : un exercice ci-dessous datant de 1950, à l’épreuve du certificat d’études, en France, et destiné à des jeunes de 13 ou 14 ans.

« La distance Paris-Reims est de 155 km par le rail. Le train de marchandises Paris-Reims démarre de la gare de l’Est à 8h30 et roule à la vitesse moyenne de 60 km/h. Un express part de Reims en direction de Paris à 9h15 et roule à la vitesse moyenne de 90 km/h. A quelle heure se croiseront-ils et à quelle distance de Paris ? »

Solution : les trains se croisent à 9h59 à 89 km de Paris. La solution tient en une équation assez simple.

Quand on donne cet exercice à des élèves de Terminale, il y a des surprises… Certains n’y parviennent pas. C’est une réalité propre à notre époque. C’est catastrophique…

Vous devez être connecté pour poster un commentaire.