Comment naît (ou faire susciter) une vocation en maths et en physique ?

Une vocation pour les maths et/ou la physique : une volonté, un plaisir, une méthode,… et des dangers à connaître.

- On devient bon en maths en travaillant régulièrement.

- On devient cancre par l’habitude de la paresse.

C’est en forgeant qu’on devient forgeron.

C’est aussi simple que cela. Avant de se lancer dans les sciences, il faut maîtriser le langage. La lecture des dictionnaires est essentielle pour comprendre les définitions des mots. Il est important d’élargir le vocabulaire.

Les maths et les sciences, comme tout domaine (comme le sport par exemple), c’est par l’envie d’apprendre et de comprendre. Le talent c’est l’envie de faire quelque chose, en y trouvant plus de plaisir que d’avoir l’impression de devoir accomplir une corvée.

Une motivation, ça arrive soudain, un jour, par un déclic, un détail, quand on recherchait soi-même une réponse à un truc. Puis la curiosité déclenche une réaction en chaîne : une boulimie d’apprendre toujours plus. Savoir qu’on peut trouver tout seul, c’est s’ouvrir à l’indépendance et la liberté. Pourquoi les profs feraient vos devoirs à votre place ? Et pourquoi (dans un tout autre contexte) laisseriez-vous des gourous penser à votre place ?

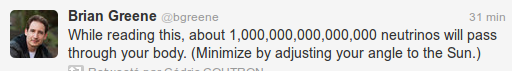

Donc bref, apprendre, être curieux, multiplier les situations à résoudre, mais disposer d’un outil précieux à ne pas négliger : l’esprit critique. Pour rester objectif. Et se souvenir des critères épistémologiques de la science, à travers le problème de la démarcation entre la science et ce qui ne relève pas de la science. Pour éviter l’amalgame entre science et mysticisme. Et se souvenir que les théories sont des représentations faillibles du réel (à travers l’observation ou l’expérimentation). Voici un exemple épistémologique très simple qui résume la scientificité : la carte n’est pas le territoire. Ces critères s’appliquent aux sciences de la nature dont la physique, les maths étant l’édifice de toutes ces sciences. J’ai dit que la carte n’est pas le territoire : en effet, les maths servent à décrire et expliquer des opérations et des expériences de physique, mais pas le contraire. C’est-à-dire que la vérité scientifique ne se construit pas d’abord sur des concepts mathématiques ou géométriques pour tenter d’inventer la réalité physique. Ainsi, le chercheur indépendant Antony Garrett Lisi (http://fr.wikiquote.org/wiki/Antony_Garrett_Lisi) avait présenté une «théorie» douteuse dans laquelle il affirme que «les équations algébriques qui décrivent le comportement de toutes les particules sont la conséquence de la géométrie d’un seul objet (Le groupe de Lie E8). Tout le contenu de l’Univers n’est donc que pure géométrie !» (source : Science et vie, nº 1084, janvier 2008, p. 51).

La physique n’a jamais été la conséquence des mathématiques. Les maths ne sont pas ladite réalité physique ni sa trame. Les maths ne sont qu’un outil pour construire une théorie abstraite à partir des faits de la physique, une théorie scientifique axiomatisée c’est elle qui est la conséquence des données quantitatives issues des observations et des expériences de physique. Les phénomènes précèdent leur théorisation, pas le contraire. On observe d’abord, afin de recueillir des données quantitatives (à travers des mesures), ensuite ces données sont comparées entre elles afin d’établir des lois physiques, puis l’on construit une théorie. Par exemple, le résultat de l’expérience de Michelson-Morley en 1887, qui contredisait l’hypothèse de départ, a eu pour conséquence la théorie de la relativité restreinte (d’Einstein) en 1905. Il est évident que l’on ne construit pas de théorie sans données physiques. Autrement, c’est brasser de l’air, c’est faire de la spéculation au risque de diverger de la méthode scientifique. Bref, une page remplie d’équations n’est pas l’univers ni la cause de l’univers, au même sens qu’une carte n’est pas le territoire, ni qu’une carte n’est la cause du territoire. Le territoire existe d’abord (il préexiste), ensuite on dessine une carte pour représenter ce territoire que l’on observe et explore (directement sur le terrain ou par vue aérienne, voire par photo satellite). On observe, puis on tire des conclusions. Mais émettre des concepts avant même d’observer ou d’expérimenter, ce n’est pas vraiment de la science.

En plus, A. Garrett Lisi annonce que «en outre, [la théorie] prédit pour l’instant une constante cosmologique gigantesque, alors que les observations la donnent très petite.» En voila un qui décide comment doivent être les faits, en dépit des observations, plutôt que reconnaître l’invalidité de la prédiction, celle-ci étant réfutée par les faits eux-même. Depuis quand une théorie est-elle dogmatiquement vraie et que les faits sont faux ? Une théorie scientifique a pour définition selon laquelle la théorie doit pouvoir être réfutée si celle-ci est fausse, donc une théorie peut être fausse. Par contre, les faits, c’est-à-dire l’observation et l’expérimentation rigoureuses des phénomènes physiques, contrairement aux interprétations qu’on en fait, ne peuvent mentir.

Dans Wikiquotes.org, la catégorie des «auteurs scientifiques» incite à s’y interroger. C’est dans ce site que j’avais pu trouver les citations de A. Garrett Lisi. Maintenant, je me penche sur le cas du chercheur japonais Masaru Emoto. Selon Wikiquote, ce chercheur étudierait les effets de la pensée sur l’eau.

À première vue, cela paraît déjà bizarre. Mais pour en avoir le cœur net, examinons les citations de M. Emoto.

Je cite Emoto :

«Les 70% environ de notre planète sont recouverts d’eau, et 70% environ du corps humain ne sont qu’eau» (

Le miracle de l’eau (2007), Masaru Emoto (trad. Gérard Leconte), éd.

Guy Trédaniel, 2008

(ISBN 978-2-84445-866-7.), p. 7 et 8)

Il est vrai que l’eau recouvre 70% de la SURFACE terrestre. Il est vrai aussi que le corps humain contient (en MASSE ou en VOLUME) environ 70% d’eau. D’une part, relier ces deux vérités n’est faire qu’une ANALOGIE, mais pas une relation de CAUSALITÉ. D’autre part, deux pourcentages similaires ne signifie rien quand les mesures concernent deux grandeurs physiques différentes : une surface n’est pas une masse ni un volume. Utiliser une telle analogie, c’est de la numérologie, non ? En effet. Quelle heure est-il ? Deux kilomètres !

Je cite encore Emoto : «D’après les cristaux, l’eau qui est en nous contient l’énergie des mots.» (du même ouvrage).

Quels cristaux ? Le chlorure de sodium de l’eau de mer ? Les sels de la composition minérale du sang humain ? L’énergie, ah ! ce terme abstrait désignant une réalité bien abstraite et quantifiable en science n’a pas d’équivalent sérieux avec l’énergie chez le domaine de la spiritualité. L’énergie des mots ? L’aptitude au langage provient d’une zone spécifique du cerveau, à peu près au sommet du crâne. Les neurosciences montrent que ce sont les neurotransmetteurs (dopamine, mélatonine, et autres) qui sont le siège de l’activité neuronale. Mais de l’énergie des mots dans l’eau, ça veut dire quoi ? C’est une métaphore ratée ? Ou une extase mystique ? Je ne trouve pas ça très rassurant… D’ailleurs, le titre «Le miracle de l’eau» ressemble à de la science-spectacle. Je pressens d’autres textes construits selon une interprétation personnelle et subjective.

Dans le jargon scientifique, chaque mot, chaque phrase, a un sens bien précis. Mais quand un texte est flou, abscons, évasif, avec un sens indéfini, des mots qui ressemblent au jargon scientifique mais selon une structure inhabituelle, alors il y a quelque chose d’anormal.

Par curiosité, je visite la biographie de Emoto (

http://fr.wikipedia.org/wiki/Masaru_Emoto) sur Wikipedia, dont je cite :

«Des scientifiques critiquent les procédures expérimentales pour leur insuffisance2 et estiment qu’il existe de nombreux biais cognitifs dans les expériences d’Emoto». Je ne suis pas étonné. On voit ensuite que Emoto a pour spécialité la «médecine alternative». Ses écrits surfent sur un thème très proche de la fameuse (fumeuse)

mémoire de l’eau (

http://fr.wikipedia.org/wiki/M%C3%A9moire_de_l%27eau) qui servit à servir d’alibi bidon à la pseudo-science homéopathique. De plus, la référence aux cristaux (quand cela ne concerne pas la minéralogie ni la cristallographie), c’est un thème irrationnel très prisé par la mouvance New Age… La page d’Emoto sur Wikipedia est classée dans la catégorie « pseudo-science ».

Ce que font les chercheurs indépendants et controversés est critiquable, certes. Mais la question essentielle est la suivante : pourquoi Wikiquote réunit-il dans sa catégorie «Scientifiques» des auteurs discutables et ayant peu publié dans des referres (Garrett Lisi, Emoto…) par rapport à des scientifiques notables par leurs travaux majeurs (Albert Einstein, Schrödinger, Max Planck, Henri Poincaré…) qui ne sont même pas recensés dans ladite catégorie ? De plus, dans la catégorie, on trouve d’autres scientifiques discutables (exemple : M. Fleischmann, co-«découvreur» de la FUSION FROIDE, «théorie» du type « fringe science », à la frontière de la pseudo-science ou de la science fictive). Il va falloir penser sérieusement à rééditer la catégorie des scientifiques chez Wikiquotes.

James Randi, le fondateur de la

James Randi Educational Foundation, a publiquement proposé d’offrir à Emoto la somme d’un million de dollars s’il pouvait reproduire les résultats de ses expériences selon la procédure en double aveugle. Les travaux d’Emoto n’ont jamais été publiés dans une

revue scientifique à comité de lecture.

Pour se proclamer scientifique, il faut respecter les critères de la méthode scientifique, que l’on fasse une découverte ou pas.

Sans esprit critique, les lecteurs gobent n’importe quoi. Jusqu’où peut-on croire ?

L’important n’est pas les réponses de la science, mais de se poser de bonnes questions.

Des questions fondamentales.

Par exemple :

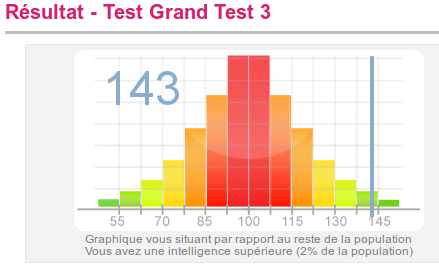

- Peut-on prouver si un test de QI est faux ? Si la question se pose pour la première fois, alors le QI n’a jamais suivi les critères de la méthode scientifique.

- Peut-on prouver si les interprétations des psychanalystes sont fausses ? S’il n’est pas du tout possible de concevoir une expérience pouvant invalider une théorie si celle-ci est fausse, alors ladite théorie est une pseudo-science.

Le talent pour les maths et les sciences, c’est autant dans la sueur que le plaisir. Rien ne tombe tout seul du ciel. Rien n’est acquis si on ne fait rien.

Le professionnalisme dans les sciences, c’est dans la rigueur par rapport à la méthode scientifique, par le devoir de rester objectif et critique. L’imposture du mysticisme et des pseudo-sciences, tout comme les fraudes scientifiques, ça n’a pas sa place dans les sciences. Le plus incompréhensible n’est pas le comportement scandaleux des fautifs, mais l’indifférence des scientifiques qui sont intègres et qui sont trop occupés pour constater une certaine montée d’obscurantisme.

J’ai vu des choses atterrantes, affligeantes, sur la progression de la secte New Age dont les meneurs ont parfois jadis été scientifiques ou qui dénaturent eux-même la science… Par exemple, une médecin russe diplômée en Suisse est devenue bionutritionniste (grâce à «l’infini quantique»), un conférencier complice est prof des universités (spécialité cancérologie), puis un autre docteur russe spécialisé en «biophysique» a participé au magazine douteux « Science et Inexpliqué », ensuite un philosophe hongrois influent est un adepte du concept New Age des annales akashiques… Alors, pour être bref, le New Age envahit les milieux médicaux, universitaires et gagne même aussi les ingénieurs. C’est alarmant. Irions-nous jusqu’à voir, impuissants ou lâches, au remplacement progressif de la méthode scientifique par des idéologies mystiques ? Des croyances personnelles doivent rester privées et ne pas interférer avec les métiers scientifiques. De plus, je ne connais aucun scientifique assez crédule pour croire lui-même avec sincérité au mysticisme, enfin je ne suis pas sûr là-dessus… Pourquoi rester indifférents face à ces dérives ? Le problème est très sous-estimé, à mon avis. C’est grave.

À travers la vulgarisation scientifique et la naissance des vocations scientifiques, la première chose à enseigner est la définition de la science (qu’est-ce que la science ?), les critères épistémologiques de scientificité, et les détails de la méthode scientifique. Pour anecdote, au collège et au lycée, on m’a appris les sciences avant même les définitions fondamentales. Ce n’est qu’avec la documentation hors scolarité que je me suis aperçu qu’il existait une grave lacune dans l’enseignement des sciences. C’est cette lacune qui m’a incité à créer mon blog en 2007, parce qu’il faut réparer ce problème. https://jpcmanson.wordpress.com/2011/12/03/definition-de-la-science/

© 2013 John Philip C. Manson

Vous devez être connecté pour poster un commentaire.